MindSpore Transformers 文档

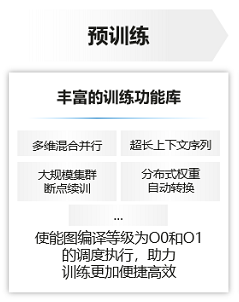

MindSpore Transformers(也称MindFormers)是一个MindSpore原生的大模型套件,旨在提供大模型训练、微调、评估、推理、部署等全流程开发能力,提供业内主流的Transformer类预训练模型和SOTA下游任务应用,涵盖丰富的并行特性,期望帮助用户轻松地实现大模型训练和创新研发。

用户可以参阅 整体架构 和 模型库 ,快速了解MindSpore Transformers的系统架构,及所支持的功能特性和大模型清单。进一步地,可参考 安装 和 快速启动 章节,上手探索MindSpore Transformers。

如果您对MindSpore Transformers有任何建议,请通过 issue 与我们联系,我们将及时处理。

MindSpore Transformers支持一键启动任意任务的单卡/多卡训练、微调、评估、推理流程,它通过简化操作、提供灵活性和自动化流程,使得深度学习任务的执行变得更加高效和用户友好,用户可以通过以下说明文档进行学习:

|

|

|

|

|

代码仓地址: <https://gitee.com/mindspore/mindformers>

使用MindSpore Transformers进行灵活易用的个性化配置

MindSpore Transformers以其强大的功能集,为用户提供了灵活易用的个性化配置选项。其关键特性包括:

-

提供统一的权重转换工具,能够将模型权重在HuggingFace所使用的格式与MindSpore Transformers所使用的格式之间相互转换。

-

不同分布式场景下的权重灵活地进行切分与合并。

-

一键配置多维混合分布式并行,让模型在上至万卡的集群中高效运行。

-

支持多种类型和格式的数据集。

-

支持step级断点续训,有效减少大规模训练时意外中断造成的时间和资源浪费。

-

提供大模型训练阶段的可视化服务,用于监控和分析训练过程中的各种指标和信息。

-

提供大模型训练阶段的高可用能力,包括临终 CKPT 保存、UCE 故障容错恢复和进程级重调度恢复功能。

-

支持safetensors格式的权重文件保存及加载功能。

-

支持细粒度地选择特定激活值使能SWAP,用于降低模型训练的峰值内存开销。